Claude Code, MCP e o Ecossistema de Plugins: Análise Técnica, Ciclos de Hype e Comportamento de Manada no Mercado de Ferramentas de IA

Análise acadêmica do ecossistema Claude Code, Model Context Protocol (MCP) e ferramentas de IA para desenvolvimento, desde a perspectiva técnica e da economia comportamental. Examina ciclos de hype, comportamento de manada e propõe critérios para adoção racional baseados na teoria dos custos de transação.

Resumo Executivo

Cinco achados centrais desta análise:

- O Model Context Protocol (MCP) representa avanço estrutural -- a migração de plugins proprietários para protocolo aberto reduz custos de transação de integração, mas a velocidade de adoção carrega componentes de cascata informacional (Banerjee, 1992).

- A divergência entre adoção crescente (76% para 84%) e satisfação decrescente (70%+ para 60%) configura padrão documentado de bolha especulativa parcial, consistente com o modelo de Shiller (2015) e as cinco características compartilhadas de bolhas tecnológicas identificadas por Floridi (2024).

- Evidências empíricas sobre produtividade são heterogêneas e contexto-dependentes: ganhos de +55,8% em tarefas simples (Peng et al., 2023) coexistem com perdas de -19% para desenvolvedores experientes em projetos complexos (Becker et al./METR, 2025). O efeito nivelador documentado por Brynjolfsson et al. (2025, QJE) mostra +34% para novatos versus ganho mínimo para seniores.

- O posicionamento da IA Generativa no Vale da Desilusão do Gartner Hype Cycle 2025 sinaliza maturação, não obsolescência. O framework de Perez (2002) sugere que a bolha atual pode servir função econômica de financiamento de infraestrutura, mas Acemoglu e Johnson (2023) alertam que prosperidade compartilhada depende de escolhas institucionais, não de determinismo tecnológico.

- Critérios de adoção racional devem privilegiar mensurabilidade, reversibilidade, interoperabilidade, governança e custo real de transação -- consistentes com a economia dos custos de transação de Williamson (1985) e sua aplicação contemporânea à economia digital (Nagle, Seamans e Tadelis, 2025).

Palavras-chave: Claude Code; Model Context Protocol; ferramentas de IA para desenvolvimento; ciclo de hype; comportamento de manada; bolha de mercado; economia comportamental.

1. Introdução

O mercado de ferramentas de inteligência artificial para desenvolvimento de software atingiu US$ 4,91 bilhões em 2024, com projeção de US$ 30,1 bilhões até 2032 -- taxa de crescimento anual composta (CAGR) de 27,1% (Second Talent, 2025). A pesquisa Stack Overflow Developer Survey 2025 confirma a dimensão do fenômeno: 84% dos desenvolvedores utilizam ou planejam utilizar ferramentas de IA, com adoção semanal de 65% entre os respondentes.

Dados do Stanford HAI AI Index 2025 ampliam a perspectiva macroeconômica: o investimento corporativo em inteligência artificial atingiu US$ 252,3 bilhões globalmente, enquanto o custo de inferência -- executar modelos treinados -- reduziu-se em 280 vezes desde novembro de 2022. Esta redução dramática nos custos operacionais é condição estrutural para a democratização das ferramentas de IA generativa.

Complementarmente, o Anthropic Economic Index (janeiro de 2026) oferece perspectiva granular sobre o impacto econômico: 49% dos empregos analisados utilizam Claude para 25% ou mais de suas tarefas; a aumentação (52%) supera a automação (45%) como padrão dominante de uso; e a IA reduz o tempo de execução de tarefas em 80% na média. Esses dados sugerem que o impacto não é substituição massiva, mas transformação da natureza das tarefas dentro de funções existentes.

Nesse contexto, a Anthropic -- empresa fundada em 2021 por ex-pesquisadores da OpenAI -- posiciona o Claude Code como agente de codificação operável em terminal, IDEs (VS Code, JetBrains, Cursor), interface web (claude.ai/code) e aplicação desktop. Diferentemente de ferramentas de autocompleção, o Claude Code opera como agente autônomo capaz de executar sequências de ações em repositórios de código, coordenar subagentes especializados e interagir com sistemas externos via hooks e o Model Context Protocol (MCP).

O MCP, lançado em novembro de 2024 como protocolo aberto, propõe solucionar um problema estrutural: a integração entre modelos de linguagem e ferramentas externas. Inspirado no Language Server Protocol (LSP) que padronizou a comunicação entre editores de código e servidores de linguagem, o MCP visa criar camada de interoperabilidade que elimine a fragmentação do ecossistema de agentes de IA.

A questão de pesquisa que orienta esta análise é: em que medida a adoção de ferramentas de IA para desenvolvimento segue padrões de comportamento de manada, e como distinguir avanços substantivos de ciclos inflacionários de hype?

O artigo organiza-se segundo a estrutura IMRAD adaptada. A Seção 2 apresenta materiais e métodos -- taxonomia do ecossistema, framework analítico e fontes de dados. A Seção 3 reporta resultados -- linha temporal, arquitetura técnica, dados de adoção e evidências empíricas sobre produtividade. A Seção 4 discute implicações -- ciclo de hype, comportamento de manada, paralelos com bolhas tecnológicas, economia de plataformas e critérios para adoção racional. A Seção 5 apresenta conclusões e direções futuras.

2. Materiais e Métodos

2.1 Taxonomia do Ecossistema Claude

O ecossistema Claude para desenvolvimento de software organiza-se em quatro camadas complementares:

| Camada | Componente | Função | Lançamento |

|---|---|---|---|

| Plataforma | Claude (API/Web) | Modelo de linguagem base com capacidades de raciocínio, análise e geração de código | Mar/2023 |

| Terminal/CLI | Claude Code | Agente de codificação em linha de comando com acesso ao sistema de arquivos, execução de comandos e coordenação de subagentes | Mai/2025 |

| IDE | Extensões VS Code, JetBrains, Cursor | Integração em ambientes de desenvolvimento com contexto de projeto, navegação de código e refatoração assistida | 2024-2025 |

| Protocolo | Model Context Protocol (MCP) | Protocolo aberto (JSON-RPC 2.0) para integração padronizada entre modelos de IA e ferramentas/dados externos | Nov/2024 |

Essa taxonomia revela arquitetura de plataforma multi-camada, onde cada camada complementa as demais e o MCP funciona como tecido conectivo que permite extensibilidade sem acoplamento proprietário.

2.2 Framework Analítico

A análise emprega três lentes teóricas complementares:

Modelo do Gartner Hype Cycle. O ciclo de hype (Fenn e Raskino, 2008) descreve cinco fases pelas quais tecnologias emergentes tipicamente transitam: (1) Gatilho de Inovação, (2) Pico de Expectativas Inflacionadas, (3) Vale da Desilusão, (4) Rampa de Esclarecimento, e (5) Platô de Produtividade. Cabe notar que a validade empírica universal do modelo é contestada: análise da revista The Economist concluiu que apenas cerca de um quinto das tecnologias rastreadas seguem o ciclo completo de cinco fases. Não obstante, o modelo oferece vocabulário analítico útil para categorizar o estágio de maturidade percebida.

Comportamento de manada e cascatas informacionais. A teoria de cascatas informacionais de Banerjee (1992) demonstra que agentes racionais podem ignorar informação privada e imitar decisões observáveis de predecessores, gerando convergência comportamental que não reflete necessariamente fundamentos. Shiller (2015) estende a análise para mercados especulativos, documentando como narrativas alimentam ciclos de retroalimentação entre entusiasmo e valorização. Floridi (2024), em artigo no Philosophy & Technology, identifica cinco características compartilhadas entre bolhas tecnológicas históricas: (1) tecnologia potencialmente disruptiva, (2) especulação excedendo a realidade, (3) novos paradigmas de valoração, (4) participação significativa de investidores de varejo, e (5) regulação inadequada. Perez (2002), em Technological Revolutions and Financial Capital, propõe que revoluções tecnológicas seguem duas fases -- instalação (onde bolhas funcionalmente financiam infraestrutura) e implantação (onde a tecnologia madura gera "eras douradas"). Sun (2013), em estudo longitudinal publicado no MIS Quarterly, identifica dois conceitos centrais no comportamento de manada em adoção tecnológica: "descontar informação própria" e "imitar outros" -- e demonstra que a adoção motivada por herding é frágil e facilmente revertida pós-adoção.

Economia dos custos de transação. O framework de Williamson (1985) -- especificidade de ativos, frequência e incerteza como determinantes de estruturas de governança -- oferece critérios objetivos para avaliar decisões de adoção tecnológica. Nagle, Seamans e Tadelis (2025), em artigo na Strategic Organization, demonstram que o framework williamsoniano permanece aplicável à economia digital contemporânea, fornecendo lente analítica para compreender a economia de plataformas e decisões estratégicas em ecossistemas digitais.

2.3 Fontes de Dados

A análise baseia-se em fontes primárias e secundárias:

- Pesquisas de mercado: Stack Overflow Developer Survey 2025 (n > 65.000 desenvolvedores), Greptile State of AI Coding 2025, Gartner Hype Cycle for AI 2025, Gartner Magic Quadrant for AI Code Assistants (setembro 2025)

- Relatórios de pesquisa: Stanford HAI AI Index Report 2025, CB Insights AI Coding Market Report (dezembro 2025), McKinsey Digital 2024

- Estudos acadêmicos: Brynjolfsson et al. (2025, QJE), Peng et al. (2023), Cui et al. (2025, SSRN), Becker et al./METR (2025), Santos et al. (2025, arXiv), Hasan et al. (2025, arXiv), Chen et al. (2025, arXiv)

- Documentação técnica: Documentação oficial Anthropic (Claude Code, MCP), Linux Foundation AAIF, especificação MCP

- Pesquisa interna Anthropic: Anthropic Economic Index (janeiro 2026), estudo interno com 132 engenheiros (2025)

3. Resultados

3.1 Linha Temporal do Ecossistema

A evolução do ecossistema de ferramentas de IA para desenvolvimento pode ser mapeada em marcos cronológicos que revelam tanto a velocidade de inovação quanto padrões de adoção em cascata:

- Novembro 2022: Lançamento do ChatGPT pela OpenAI. Marca o início da adoção massiva de modelos de linguagem pelo público geral. Atinge 100 milhões de usuários em dois meses -- a adoção mais rápida da história de aplicações de consumo.

- Março 2023: ChatGPT Plugins. Primeira tentativa de ecossistema de integração entre modelo de linguagem e ferramentas externas. Modelo proprietário, curadoria centralizada, acesso restrito.

- Março 2023: Lançamento do Claude pela Anthropic. Modelo com foco em segurança e alinhamento, posicionando-se como alternativa ao GPT.

- Março 2024: Claude 3 Opus. Primeiro modelo a competir consistentemente com GPT-4 em benchmarks de raciocínio e codificação.

- Junho 2024: ChatGPT Plugins descontinuados pela OpenAI. Substituídos por GPTs customizados -- reconhecimento implícito de que o modelo de plugins proprietários não escalou.

- Novembro 2024: Lançamento do MCP pela Anthropic como protocolo aberto. Especificação JSON-RPC 2.0 publicada sob licença permissiva.

- Março 2025: OpenAI adota o MCP. Evento significativo: o principal concorrente adota protocolo criado pela Anthropic, validando a abordagem de padrão aberto.

- Maio 2025: Google e Microsoft anunciam suporte ao MCP em suas plataformas de IA.

- Maio 2025: Claude Code lançado em disponibilidade geral como agente de codificação.

- Setembro 2025: MCP Registry atinge aproximadamente 2.000 servidores catalogados. Ecossistema em rápida expansão.

- Setembro 2025: Gartner publica primeiro Magic Quadrant for AI Code Assistants. Mercado estimado em US$ 3,0-3,5 bilhões.

- Dezembro 2025: MCP doado à Agentic AI Foundation (AAIF), entidade sob a Linux Foundation. Membros fundadores: Anthropic, Block, OpenAI. Membros platinum: AWS, Google, Microsoft, Cloudflare.

- Janeiro 2026: Gartner Hype Cycle for AI 2025 posiciona IA Generativa no Vale da Desilusão. Agentes de IA no Pico de Expectativas Inflacionadas.

- Fevereiro 2026: Ecossistema consolidado com múltiplas superfícies de uso e adoção empresarial crescente.

Essa linha temporal revela três padrões notáveis: (1) a velocidade de transição de experimento a padrão em 12 meses (MCP), (2) a falha do modelo proprietário de plugins e a emergência do modelo aberto, e (3) a adoção em cascata onde cada ator subsequente carrega menos informação independente.

3.2 Claude Code: Arquitetura e Superfícies de Uso

O Claude Code opera como agente de codificação com quatro superfícies de uso complementares:

Terminal/CLI. Superfície original. O desenvolvedor interage via linha de comando, delegando tarefas de codificação, depuração, refatoração e análise. O agente tem acesso ao sistema de arquivos, pode executar comandos shell, ler e modificar código, e coordenar múltiplas ações sequenciais.

IDE (VS Code, JetBrains, Cursor). Integração direta no ambiente de desenvolvimento. Contexto de projeto disponível automaticamente. Navegação de código, refatoração assistida, geração de testes e revisão de pull requests integrados ao fluxo de trabalho existente.

Web/Mobile (claude.ai/code). Interface web que permite interação com Claude Code sem instalação local. Repositórios conectados via GitHub. Útil para revisão de código, análise de arquitetura e planejamento de implementação.

Desktop App. Aplicação nativa que combina funcionalidades de terminal e IDE com interface gráfica dedicada.

CLAUDE.md como Memória de Projeto. Elemento arquitetural distintivo: o arquivo CLAUDE.md funciona como memória persistente do projeto. Contém instruções, padrões, preferências e contexto que o agente carrega automaticamente em cada sessão. Santos et al. (2025), em estudo de 328 arquivos CLAUDE.md públicos disponíveis no GitHub (arXiv:2511.09268), identificaram padrões de configuração que incluem convenções de código, restrições de segurança, preferências de comunicação e instruções de workflow -- evidenciando que desenvolvedores tratam o CLAUDE.md como artefato de engenharia de software, não mero prompt.

Subagentes. O Claude Code pode coordenar subagentes especializados -- cada um com sua própria janela de contexto -- para tarefas como revisão de código, depuração, análise de arquitetura e refatoração. Esse modelo de coordenação multi-agente permite paralelismo e especialização dentro de uma sessão.

Hooks. Mecanismo para execução de comandos shell em pontos específicos do fluxo de trabalho do agente. Permite automação de tarefas como linting, formatação, execução de testes e deploy em resposta a ações do agente.

Dados internos da Anthropic (2025). Pesquisa interna com 132 engenheiros da própria Anthropic revelou evolução significativa: a complexidade das tarefas delegadas ao Claude Code subiu de 3,2 para 3,8 (escala de 1 a 5); o agente agora executa aproximadamente 20 ações autônomas por sessão (comparado a 10 anteriormente); e requer 33% menos turnos de interação humana por tarefa. Esses dados, embora limitados ao contexto interno de uma empresa de IA, indicam trajetória de aumento da autonomia e sofisticação do agente.

O ecossistema Claude Code é relevante para empresas que buscam eficiência em desenvolvimento web, embora a adoção deva ser avaliada com os critérios discutidos na Seção 4.5.

3.3 Model Context Protocol: De Plugins Proprietários a Padrão Aberto

O MCP resolve um problema estrutural que a indústria enfrentava desde os primeiros assistentes de IA: o problema N x M de integração. Sem protocolo padronizado, cada modelo de IA (N modelos) precisa de integração customizada com cada ferramenta ou fonte de dados (M ferramentas), resultando em N x M implementações. Com protocolo padronizado, cada modelo implementa o lado cliente do protocolo e cada ferramenta implementa o lado servidor, reduzindo para N + M implementações.

A inspiração declarada é o Language Server Protocol (LSP), que resolveu problema análogo para editores de código na década de 2010. Antes do LSP, cada editor precisava de plugin específico para cada linguagem de programação. O LSP padronizou a interface, permitindo que qualquer editor se comunicasse com qualquer servidor de linguagem.

O MCP opera sobre JSON-RPC 2.0, protocolo leve para chamadas de procedimento remoto. A arquitetura define três primitivas:

- Tools (ferramentas): funções que o modelo pode invocar para executar ações (buscar dados, executar comandos, interagir com APIs)

- Resources (recursos): dados contextuais que o servidor disponibiliza para o modelo (documentos, bases de dados, estados de aplicação)

- Prompts (templates): instruções pré-definidas que guiam o comportamento do modelo em contextos específicos

Linha temporal de adoção do MCP:

A trajetória de adoção é notavelmente rápida para um protocolo técnico:

- Novembro 2024: Anthropic publica especificação MCP como código aberto.

- Março 2025: OpenAI anuncia suporte ao MCP em suas plataformas. Evento-chave: o principal concorrente adota protocolo do rival, sinalizando que o valor do padrão aberto supera a rivalidade competitiva.

- Maio 2025: Google (Gemini) e Microsoft (Azure AI) anunciam suporte. Efeito cascata completo entre os três maiores players.

- Setembro 2025: MCP Registry cataloga aproximadamente 2.000 servidores disponíveis. Ecossistema abrange bancos de dados, APIs, ferramentas de desenvolvimento, serviços de nuvem, plataformas de comunicação.

- Dezembro 2025: MCP doado à Agentic AI Foundation (AAIF), nova entidade sob a Linux Foundation. Membros fundadores: Anthropic, Block (Square/Cash App), OpenAI. Membros platinum: AWS, Google, Microsoft, Cloudflare. A governança institucional visa garantir neutralidade e evolução orientada pela comunidade.

Análise de segurança e maturidade.

Dois estudos acadêmicos recentes oferecem avaliação crítica da maturidade do ecossistema MCP:

Hasan et al. (2025, arXiv:2503.23278) publicaram estudo sistemático definindo o ciclo de vida do MCP em quatro fases com 16 atividades-chave, além de taxonomia abrangente de ameaças que identifica quatro tipos de atacantes (servidor malicioso, cliente malicioso, man-in-the-middle, e envenenamento de ferramenta). O estudo conclui que a segurança do MCP depende criticamente da implementação, não apenas da especificação.

Chen et al. (2025, arXiv:2506.13538) conduziram estudo empírico de 1.899 servidores MCP de código aberto. Os resultados são reveladores: 7,2% contêm vulnerabilidades de segurança identificáveis, 5,5% exibem envenenamento de ferramenta (tool poisoning), 66% apresentam code smells significativos, e 14,4% contêm padrões de bug documentados. Esses números indicam ecossistema em estágio inicial de maturidade, onde a velocidade de crescimento superou a consolidação de práticas de qualidade.

A relevância do MCP para estratégias de presença digital é analisada no contexto de Generative Engine Optimization, onde protocolos de integração determinam como agentes de IA acessam e apresentam informação.

3.4 Comparação: Plugins Proprietários vs. MCP

| Dimensão | Plugins Proprietários (ex: ChatGPT Plugins) | Model Context Protocol (MCP) |

|---|---|---|

| Vendor lock-in | Alto -- cada plataforma requer implementação específica | Baixo -- implementação única funciona com múltiplos clientes |

| Custo de desenvolvimento | N x M (cada modelo x cada ferramenta) | N + M (cada modelo + cada ferramenta) |

| Governança | Centralizada na plataforma (curadoria, aprovação, distribuição) | Descentralizada via Linux Foundation (AAIF) |

| Segurança | Modelo curadoria (plataforma aprova/rejeita) | Modelo responsabilidade distribuída (cada implementação) |

| Ecossistema | Fechado, controlado, crescimento limitado | Aberto, não curado, crescimento acelerado |

| Contexto | Limitado ao que a plataforma permite | Extensível via resources e prompts customizados |

A transição de modelo proprietário para protocolo aberto reflete padrão recorrente na história da tecnologia: sistemas fechados geram adoção inicial rápida mas atingem limites de escalabilidade; protocolos abertos iniciam mais lentamente mas permitem ecossistema mais amplo e resiliente. HTTP, SMTP, TCP/IP e o próprio LSP seguiram trajetória similar.

3.5 Dados de Adoção e Sentimento

Stack Overflow Developer Survey 2025:

| Indicador | 2024 | 2025 | Variação |

|---|---|---|---|

| Uso ou plano de uso de ferramentas de IA | 76% | 84% | +8 p.p. |

| Sentimento favorável em relação a ferramentas de IA | 70%+ | ~60% | -10 p.p. |

| Frustração: "soluções quase certas mas não completamente" | -- | 66% | (nova métrica) |

| Não usam agentes ou limitam-se a ferramentas simples | -- | 52% | -- |

| Não planejam adotar agentes de IA | -- | 38% | -- |

O padrão é revelador: aumento de uso simultâneo à diminuição de satisfação. Em mercados de consumo, esse padrão tipicamente precede correção -- agentes continuam consumindo por inércia ou pressão social, mas a satisfação decrescente erode a base de sustentação. No framework do Gartner, essa combinação é consistente com a transição do Pico de Expectativas Inflacionadas para o Vale da Desilusão.

Greptile State of AI Coding 2025:

Dados complementares revelam impacto quantitativo na prática de desenvolvimento:

- Tamanho médio de pull requests aumentou 33%

- Linhas de código por desenvolvedor: de 4.450 para 7.839

- Adoção de CLAUDE.md em projetos: 67%

- Downloads do Anthropic SDK: 43 milhões (crescimento de 8x)

Esses números devem ser interpretados com cautela: mais linhas de código não equivalem necessariamente a mais valor -- podem indicar código gerado sem curadoria adequada. O aumento de 33% no tamanho de PRs pode refletir tanto produtividade genuína quanto inflação de código não revisado.

CB Insights (dezembro 2025):

O relatório CB Insights sobre o mercado de IA para codificação estima que o mercado atingiu US$ 4 bilhões. Os três líderes -- GitHub Copilot, Claude Code e Cursor -- capturam mais de 70% de market share. Dado notável: o Claude Code escalou de US$ 0 a US$ 400 milhões em receita anual recorrente (ARR) em cinco meses, uma das trajetórias de crescimento mais aceleradas na história de produtos SaaS B2B.

Gartner Magic Quadrant for AI Code Assistants (setembro 2025):

O primeiro Magic Quadrant dedicado ao segmento estima mercado de US$ 3,0 a 3,5 bilhões e projeta que 90% dos engenheiros de software em empresas utilizarão assistentes de IA até 2028 -- comparado a menos de 14% no início de 2024. A institucionalização do segmento pelo Gartner -- que reserva Magic Quadrants para mercados que considera maduros o suficiente para avaliação comparativa -- é em si sinal de consolidação.

3.6 Evidências Empíricas sobre Produtividade com IA

A avaliação rigorosa do impacto de ferramentas de IA sobre a produtividade de desenvolvedores requer análise de estudos controlados, não apenas relatos anedóticos ou métricas de adoção. Quatro estudos com metodologia experimental (RCT ou quasi-experimental) oferecem evidências que, combinadas, revelam quadro nuançado e heterogêneo:

| Estudo | Amostra | Resultado Principal | Contexto | Publicação |

|---|---|---|---|---|

| Peng et al. (2023) | 95 desenvolvedores | +55,8% velocidade | Tarefa simples (servidor HTTP em JavaScript) | arXiv |

| Brynjolfsson et al. (2025) | 5.179 agentes | +14% produtividade | Suporte ao cliente (atendimento técnico) | QJE (periódico top) |

| Cui et al. (2025) | 4.867 desenvolvedores | +26,08% tarefas concluídas | Microsoft, Accenture, Fortune 100 | SSRN |

| Becker et al./METR (2025) | 16 desenvolvedores seniores | -19% velocidade | Projetos open-source complexos e familiares | arXiv (RCT) |

Análise dos resultados:

Peng et al. (2023): Primeiro RCT publicado sobre o impacto de assistentes de IA (GitHub Copilot) na produtividade de programação. Os 95 desenvolvedores que usaram Copilot completaram a tarefa -- implementar um servidor HTTP em JavaScript -- 55,8% mais rápido. Limitação crítica: tarefa simples, bem definida, com escopo limitado. A generalização para tarefas complexas é questionável.

Brynjolfsson et al. (2025, QJE): Estudo publicado no The Quarterly Journal of Economics -- um dos periódicos mais prestigiados em economia --, portanto com rigor metodológico substancial. Analisou 5.179 agentes de suporte ao cliente com acesso a assistente de IA baseado em GPT. Resultado agregado: +14% em produtividade. Mas o achado mais relevante é o efeito nivelador: novatos apresentaram ganho de +34%, enquanto agentes experientes tiveram ganho mínimo. A interpretação dos autores: a IA dissemina as melhores práticas dos profissionais de alta performance para toda a equipe, reduzindo a variância de desempenho.

Cui et al. (2025): Estudo de larga escala com 4.867 desenvolvedores em três organizações (Microsoft, Accenture e empresa Fortune 100). Resultado agregado: +26,08% em tarefas concluídas. Efeitos heterogêneos confirmados: desenvolvedores juniores apresentaram ganho de +35% a +39%, enquanto seniores obtiveram apenas +8% a +16%. A consistência com o efeito nivelador de Brynjolfsson et al. reforça a robustez do padrão.

Becker et al./METR (2025): Estudo mais provocativo e metodologicamente rigoroso entre os quatro. Ensaio controlado randomizado (RCT) com 16 desenvolvedores experientes trabalhando em seus próprios projetos open-source -- projetos que conheciam profundamente. Resultado: -19% de velocidade com uso de ferramentas de IA (Claude e Cursor). Os desenvolvedores PREVIRAM ganho de 24% antes do experimento, ESTIMARAM ganho de 20% após concluí-lo, mas o resultado REAL foi perda de 19%. Essa discrepância entre percepção e realidade é fascinante e merece atenção.

O estudo METR identificou cinco fatores contribuintes para a desaceleração:

- Tempo gasto revisando output de IA -- código gerado requer revisão cuidadosa, consumindo tempo que seria usado na produção direta

- Alternância de contexto (context switching) -- interação com ferramenta de IA fragmenta o fluxo de trabalho cognitivo

- Excesso de confiança em código gerado -- aceitação insuficientemente crítica de sugestões introduz defeitos

- Depuração de erros gerados pela IA -- quando a IA erra, a depuração é frequentemente mais complexa do que seria a implementação manual

- Overhead de engenharia de prompt -- formular instruções precisas consome tempo que, para especialistas em projetos familiares, excede o ganho

McKinsey (2024):

Relatório da McKinsey Digital sobre produtividade de desenvolvedores com IA generativa reporta aceleração de até 2x em tarefas selecionadas, com mais de 90% das equipes utilizando IA para tarefas centrais de engenharia. Equipes de alto desempenho reportaram melhoria de 16% a 30% em produtividade. O relatório nota, contudo, que a definição e mensuração de "produtividade" em desenvolvimento de software permanece desafio metodológico não trivial.

Anthropic Economic Index (janeiro 2026):

O índice econômico da Anthropic estima que a IA reduz o tempo de execução de tarefas em 80% na média, e poderia aumentar o crescimento da produtividade do trabalho nos EUA em 1,8% ao ano -- efetivamente dobrando as taxas recentes de crescimento de produtividade. Essas projeções, vindas da empresa que comercializa a ferramenta, devem ser ponderadas pelo potencial conflito de interesse, mas são consistentes com as magnitudes observadas nos estudos acadêmicos para tarefas específicas.

Segurança do código gerado por IA:

Estudo publicado na ACM Transactions on Software Engineering and Methodology (TOSEM) em 2025 analisou 733 trechos de código gerados pelo GitHub Copilot em projetos reais do GitHub. Resultados: 29,5% dos trechos em Python e 24,2% dos trechos em JavaScript continham fraquezas de segurança distribuídas em 43 categorias CWE (Common Weakness Enumeration). Os ganhos de produtividade, portanto, vêm acompanhados de riscos mensuráveis de segurança que devem ser gerenciados explicitamente.

Síntese:

As evidências empíricas convergem em três proposições:

-

Ganhos são reais mas contexto-dependentes. Tarefas simples, bem definidas e executadas por desenvolvedores menos experientes apresentam ganhos consistentes. Tarefas complexas executadas por especialistas em projetos familiares podem apresentar perda líquida.

-

Efeito nivelador é o padrão mais robusto. Replicado em dois estudos independentes (Brynjolfsson/QJE e Cui/SSRN), o efeito de redução da variância de desempenho -- novatos ganham mais, seniores ganham menos ou perdem -- é o achado mais consistente.

-

Percepção excede realidade. O estudo METR documenta discrepância significativa entre o ganho percebido (+20-24%) e o ganho real (-19%). Essa lacuna entre percepção e realidade é consistente com padrões de cascata informacional -- agentes adotam a ferramenta baseados em narrativa de produtividade, não em mensuração rigorosa.

Essas evidências são relevantes para organizações que avaliam investimento em ferramentas de IA como parte de suas estratégias de marketing de conteúdo e produção digital.

4. Discussão

4.1 Ciclo de Hype: Posicionamento Atual

O Gartner Hype Cycle for AI 2025 posiciona três tecnologias relevantes em estágios distintos:

| Tecnologia | Posição no Hype Cycle | Implicação |

|---|---|---|

| IA Generativa | Vale da Desilusão | Expectativas recalibradas; retornos mensuráveis emergindo |

| Agentes de IA | Pico de Expectativas Inflacionadas | Entusiasmo máximo; lacuna entre promessa e entrega se formando |

| Engenharia de Software AI-native | Gatilho de Inovação | Emergente; potencial não testado em escala |

O posicionamento da IA Generativa no Vale da Desilusão não indica obsolescência, mas recalibração. Em 2024, a empresa média investiu US$ 1,9 milhão em projetos de IA generativa, mas menos de 30% dos CEOs declararam-se satisfeitos com o retorno obtido. A lacuna entre investimento e satisfação é característica definidora do Vale da Desilusão.

O posicionamento simultâneo de Agentes de IA no Pico de Expectativas Inflacionadas é relevante para a análise do Claude Code: enquanto o modelo de linguagem subjacente (IA generativa) atravessa fase de recalibração, a camada agêntica -- que inclui Claude Code, MCP e o ecossistema de ferramentas -- está no momento de máximo entusiasmo. Historicamente, tecnologias que se encontram simultaneamente nesses dois estágios enfrentam pressão descendente quando o entusiasmo da camada agêntica encontra as limitações da camada de modelo.

Floridi (2024), em artigo no Philosophy & Technology, identifica cinco características compartilhadas entre a atual onda de IA e bolhas tecnológicas anteriores: (1) tecnologia potencialmente disruptiva -- a IA generativa de fato altera modos de produção; (2) especulação excedendo a realidade -- investimentos e valuations desproporcionais aos resultados demonstráveis; (3) novos paradigmas de valoração -- métricas como "receita por GPU" substituem métricas tradicionais; (4) participação significativa de investidores de varejo -- através de ações de empresas de IA e produtos de consumo; (5) regulação inadequada -- frameworks regulatórios em construção enquanto a tecnologia avança. A presença simultânea das cinco características é, segundo Floridi, indicativa de dinâmica de bolha.

4.2 Comportamento de Manada e Cascatas Informacionais

Três padrões observáveis nos dados são consistentes com comportamento de manada documentado na literatura:

1. Adoção mimética.

O dado de 84% de uso ou plano de uso é frequentemente citado como evidência de consenso informado. Análise granular revela nuances: 52% dos desenvolvedores não usam agentes de IA ou limitam-se a ferramentas simples de autocompleção; 38% não planejam adotar agentes. A lacuna entre "planejar usar" e "efetivamente usar de forma sofisticada" sugere pressão de prova social como motor de adoção declarada, não avaliação independente de valor.

Sun (2013, MIS Quarterly) oferece framework explicativo: em seu estudo longitudinal, identificou que a adoção motivada por herding -- "descontar informação própria" e "imitar outros" -- é estruturalmente frágil. Quando a narrativa de consenso enfraquece, a adoção motivada por imitação reverte-se mais rapidamente do que a adoção baseada em avaliação independente. A implicação para ferramentas de IA: uma parcela significativa da adoção atual pode não ser durável.

2. Cascata de plataforma.

A sequência de adoção do MCP -- Anthropic (criador) seguida por OpenAI seguida por Google/Microsoft -- exibe estrutura clássica de cascata informacional conforme definida por Banerjee (1992). Cada ator subsequente carregou menos informação independente sobre o mérito do protocolo: a OpenAI pode ter avaliado independentemente, mas Google e Microsoft adotaram em parte porque OpenAI já havia adotado. A cascata foi reforçada por declarações como a de Jensen Huang (CEO da NVIDIA), que afirmou que o MCP "revolucionou o cenário de IA" -- sinal de autoridade que amplifica cascatas.

Vergari (2005, Journal of Economics) demonstra que complementaridades estratégicas e externalidades de rede amplificam cascatas informacionais em tecnologias de rede -- exatamente a dinâmica do ecossistema MCP. Quanto mais participantes adotam o protocolo, maior o valor para cada participante individual (externalidade de rede), o que pode amplificar adoção independentemente do mérito técnico intrínseco.

Cabe notar que a cascata, neste caso, não é necessariamente irracional: o MCP resolve problema real (integração N x M) e a adoção ampla gera valor de rede genuíno. O ponto analítico é que a velocidade de adoção excede o que avaliação puramente técnica justificaria -- componentes de herding estão presentes junto com fundamentos reais.

3. Divergência uso-satisfação.

O padrão de uso crescente (76% para 84%) com satisfação decrescente (70%+ para 60%) é documento clássico em análise de bolhas. Shiller (2015) descreve o ciclo de retroalimentação narrativa: entusiasmo gera adoção, adoção gera investimento, investimento gera narrativa de sucesso, narrativa alimenta mais entusiasmo -- até que a experiência real acumula fricção suficiente para quebrar o ciclo.

A métrica de 66% de frustração -- "soluções de IA que são quase certas mas não completamente" -- é particularmente significativa. Essa frustração específica indica que os agentes não rejeitam a tecnologia por inadequação grosseira, mas por inadequação sutil -- o que é, em muitos aspectos, mais insidioso. A solução "quase certa" é mais custosa do que a solução claramente errada, porque requer verificação detalhada para identificar onde falha.

Esse padrão conecta-se à análise de gatilhos mentais e à dinâmica de escassez como gatilho: o FOMO (fear of missing out) institucional -- "se não adotarmos IA, ficaremos para trás" -- funciona como gatilho de urgência que acelera adoção independentemente de avaliação rigorosa.

4.3 Paralelos com Bolhas Tecnológicas

A comparação com ciclos tecnológicos anteriores revela padrões recorrentes:

| Dimensão | Dot-com (1995-2001) | Cripto (2017-2022) | IA (2022-2025) |

|---|---|---|---|

| Narrativa dominante | "A internet muda tudo" | "Descentralização muda tudo" | "IA muda tudo" |

| Velocidade de adoção | Alta (empresas, investidores) | Alta (varejo, institucional) | Muito alta (todas as camadas) |

| Valuations desconectadas | Pets.com, Webvan | Tokens sem utilidade | Empresas de IA pré-receita |

| Resultado tecnológico | Internet permaneceu; empresas falharam | Blockchain permaneceu; tokens falharam | IA permanecerá; aplicações selecionarão |

| Seleção pós-crise | Amazon, Google, eBay | Ethereum, Solana (parcialmente) | Em andamento |

Indicadores macroeconômicos:

EconoFact (Tufts University) estima que o boom de IA contribuiu com aproximadamente 1% do crescimento do PIB dos EUA em 2025. A implicação é bidirecional: o boom gera atividade econômica real, mas uma desaceleração teria efeitos macroeconômicos que transcendem o setor de tecnologia.

O índice Shiller PE para as sete maiores empresas de tecnologia (inclui NVIDIA, Microsoft, Alphabet, Meta, Amazon, Apple, Tesla) aproxima-se dos níveis observados no pico da bolha dot-com -- indicador de valuations potencialmente desconectadas de fundamentos, embora a comparação direta seja limitada pela diferença de lucratividade entre empresas dot-com (muitas sem receita) e empresas de IA atuais (muitas altamente lucrativas).

Impacto no mercado de trabalho:

MIT Technology Review (dezembro de 2025) reportou que estudo de Stanford identificou queda de aproximadamente 20% no emprego de desenvolvedores na faixa etária de 22 a 25 anos entre 2022 e 2025. Embora correlação não implique causalidade -- o período coincide com ajustes pós-pandemia e recessão setorial em tech -- o dado é consistente com o cenário onde ferramentas de IA substituem parcialmente demanda por desenvolvedores juniores, exatamente o perfil que mais se beneficia das ferramentas segundo os estudos de produtividade (Brynjolfsson et al., Cui et al.).

A frustração de 66% ("quase certo mas não completamente") ecoa o padrão identificado por Floridi: expectativa desproporcionalmente alta, seguida de resultado desproporcionalmente decepcionante, não porque a tecnologia seja ruim, mas porque a narrativa foi inflada.

Perez (2002), em Technological Revolutions and Financial Capital, oferece perspectiva estrutural que transcende a dicotomia "bolha boa ou ruim": revoluções tecnológicas seguem fase de instalação (onde bolhas especulativas funcionalmente financiam a construção de infraestrutura) e fase de implantação (onde a tecnologia madura, agora com infraestrutura disponível, gera "eras douradas" de crescimento sustentado). Nesse framework, a bolha de IA não é anomalia -- é mecanismo recorrente pelo qual o capital financia infraestrutura tecnológica que será utilizada nas décadas seguintes. A bolha dot-com financiou a infraestrutura de fibra óptica e data centers que viabilizaram cloud computing e mobile; a bolha de IA pode estar financiando a infraestrutura de computação e dados que viabilizará a próxima onda de aplicações.

Contudo, Acemoglu e Johnson (2023), em Power and Progress, alertam que a tecnologia não gera automaticamente prosperidade compartilhada. Os economistas do MIT argumentam que o crescimento salarial estagnou desde 1980 devido à automação desequilibrada -- tecnologia que substitui trabalho humano sem criar demanda compensatória. Para o contexto de IA: a questão não é apenas se as ferramentas funcionam, mas quem efetivamente se beneficia. Se o efeito líquido for concentração de ganhos em empresas de tecnologia e redução de demanda por desenvolvedores juniores, o resultado agregado pode ser negativo apesar de ganhos de produtividade em nível de tarefa.

Essa reflexão é particularmente relevante para organizações avaliando estratégias de marketing para 2026, onde a decisão de investir em ferramentas de IA deve considerar não apenas eficiência individual mas impacto sistêmico.

4.4 Decepções e Falsos Hypes: Taxonomia de Falhas

A análise das frustrações documentadas permite categorizar três tipos de falha:

1. Falha de expectativa.

A taxa de aceitação de sugestões do GitHub Copilot é de aproximadamente 30% -- 70% das sugestões são descartadas ou substancialmente modificadas pelo desenvolvedor. A promessa narrativa do "desenvolvedor 10x" -- frequentemente propagada em redes sociais e conferências -- contrasta com a realidade de que depurar código gerado por IA frequentemente consome mais tempo do que a implementação manual teria requerido, especialmente para desenvolvedores experientes (Becker et al./METR, 2025).

O estudo METR é particularmente relevante aqui: desenvolvedores PREVIRAM ganho de 24%, ESTIMARAM ganho de 20% após concluírem o experimento, mas o resultado REAL foi perda de 19%. A persistência da percepção positiva mesmo após experiência negativa mensurada é consistente com viés de confirmação -- agentes mantêm crença na eficácia da ferramenta mesmo quando dados pessoais sugerem o contrário.

2. Falha de integração.

Cajic (2025) sintetiza: "a lacuna entre hype e impacto raramente é o modelo; são dados, permissões, integrações de sistema". O modelo de linguagem pode ser sofisticado, mas se não tem acesso aos dados corretos, permissões adequadas e integração com sistemas existentes, o resultado é limitado. O MCP endereça parcialmente esse problema ao padronizar a camada de integração, mas a complexidade de implementação e governança permanece.

3. Falha de governança.

A maioria das falhas de IA em produção são, fundamentalmente, falhas de governança: ausência de proprietário definido para outputs de IA, monitoramento insuficiente, critérios de avaliação fracos, revisão humana insuficiente. A ACM TOSEM (2025) documenta que 29,5% dos trechos Python e 24,2% dos trechos JavaScript gerados por Copilot contêm fraquezas de segurança em 43 categorias CWE. Os ganhos de produtividade, portanto, são parcialmente consumidos por riscos de segurança que requerem processos de governança para mitigar.

4.5 Implicações para Adoção Racional

Com base nas evidências analisadas, propõe-se cinco critérios para decisões de adoção racional:

Critérios para adoção racional de ferramentas de IA:

- Mensurabilidade: O impacto pode ser medido objetivamente? Definir métricas antes da adoção, não após. Comparar com baseline documentada.

- Reversibilidade: A decisão pode ser revertida sem custo proibitivo? Preferir ferramentas que não criam dependência irreversível.

- Interoperabilidade: A ferramenta opera com padrões abertos? MCP é preferível a integrações proprietárias, mas o ecossistema MCP em si pode gerar lock-in (ver Seção 4.6).

- Governança: Existem processos de supervisão humana, revisão de outputs, monitoramento de qualidade e segurança? A ferramenta mais poderosa sem governança adequada gera mais risco.

- Custo real de transação: Qual é o custo total de adoção -- incluindo treinamento, integração, manutenção, riscos de segurança e custo de oportunidade? Considerar especificidade de ativos, frequência e incerteza (Williamson, 1985).

Esses critérios são consistentes com a economia dos custos de transação de Williamson: decisões de adoção devem considerar especificidade de ativos (quão específico é o investimento na ferramenta?), frequência (com que regularidade a ferramenta será utilizada?) e incerteza (quão previsível é a evolução da ferramenta e do mercado?). Nagle, Seamans e Tadelis (2025), em artigo na Strategic Organization, confirmam que o framework williamsoniano permanece aplicável à economia digital contemporânea, provendo lente analítica para compreender decisões estratégicas em ecossistemas de plataformas digitais.

4.6 Economia de Plataformas e Lock-in

A análise do ecossistema Claude Code e MCP requer perspectiva de economia de plataformas, campo que examina dinâmicas de concorrência, lock-in e efeitos de rede em mercados de múltiplos lados.

Lock-in e custos de troca.

Shapiro e Varian (1999), em Information Rules, definem lock-in como situação em que altos custos de troca efetivamente prendem usuários a uma plataforma ou tecnologia. Para o contexto do Claude Code, os custos de troca acumulam-se em múltiplas dimensões:

- Arquivos CLAUDE.md: Configurações específicas do projeto que codificam conhecimento organizacional, padrões de código, preferências de fluxo de trabalho e restrições de segurança. Embora o formato seja Markdown portável, o conteúdo é otimizado para o Claude Code e não transfere diretamente para ferramentas concorrentes.

- Skills e hooks: Automações de workflow construídas em torno das capacidades específicas do agente. Representam investimento de tempo e conhecimento que não é facilmente replicável.

- Familiaridade com ecossistema MCP: Conhecimento acumulado sobre servidores MCP disponíveis, padrões de configuração e limitações. Transferível em princípio (MCP é aberto), mas a familiaridade prática é específica.

- Treinamento de equipe: Investimento em capacitação, desenvolvimento de boas práticas internas e cultura organizacional construída em torno de ferramentas específicas.

Efeitos de rede e dinâmicas de plataforma.

Rietveld e Schilling (2021), em revisão sistemática de 333 artigos sobre competição de plataformas publicada no Journal of Management, demonstram que efeitos de rede geram dinâmicas de "winner-takes-all" (vencedor leva tudo) em mercados de plataforma. Aplicado ao ecossistema MCP:

- Mais servidores MCP geram mais usuários (valor do ecossistema aumenta)

- Mais usuários atraem mais desenvolvedores de servidores MCP (incentivo de mercado)

- Mais servidores geram mais servidores (desenvolvedores aprendem com servidores existentes)

- O ciclo de retroalimentação positiva concentra o ecossistema

O paradoxo do MCP:

O MCP apresenta paradoxo analítico que merece atenção:

Por um lado, o MCP reduz vendor lock-in: qualquer cliente MCP pode comunicar-se com qualquer servidor MCP. Um desenvolvedor que migra do Claude Code para outra ferramenta com suporte MCP pode continuar usando os mesmos servidores. A padronização é genuinamente benéfica para a portabilidade.

Por outro lado, o MCP pode gerar lock-in de ecossistema: o ecossistema MCP em si torna-se a plataforma. Assim como HTTP é protocolo aberto mas o Google domina a busca na web, MCP é protocolo aberto mas a concentração do ecossistema é provável. Os dados do CB Insights (dezembro 2025) já indicam que três empresas capturam mais de 70% do market share em ferramentas de codificação com IA.

A analogia é instrutiva: HTTP não gera lock-in para nenhum servidor web específico, mas o ecossistema web gera lock-in para o ecossistema web em si. Da mesma forma, MCP não gera lock-in para nenhuma ferramenta específica, mas o ecossistema de agentes de IA com MCP pode gerar lock-in para esse modo de trabalho.

A governança pela Linux Foundation (AAIF) pode mitigar mas não eliminar dinâmicas de concentração. Precedentes históricos são mistos: a Linux Foundation governa projetos como Kubernetes e Linux que mantêm diversidade de participantes, mas também projetos onde a governança aberta coexiste com concentração prática (ex: contribuições ao Linux kernel são dominadas por um pequeno número de empresas).

Implicações práticas para organizações:

- Avaliar custos de troca antes que a adoção se aprofunde. O momento de menor custo de troca é antes da acumulação significativa de configurações, workflows e conhecimento tácito.

- Preferir ferramentas que exportam configurações. O CLAUDE.md é Markdown portável -- mérito do design. Verificar se outras configurações (skills, hooks, preferências) são igualmente exportáveis.

- Monitorar métricas de concentração do ecossistema. Participação de mercado dos três maiores, proporção de servidores MCP mantidos por empresas vs. comunidade, diversidade de clientes MCP ativos.

- Manter opcionalidade. Investir em competências que transferem entre ferramentas (princípios de engenharia de software, revisão de código, design de sistemas) mais do que em competências específicas de uma ferramenta.

Essa análise de plataformas é relevante para estratégias de funil de vendas e inbound marketing, onde decisões de adoção de ferramentas afetam a estrutura de custos de longo prazo.

5. Conclusão

A análise do ecossistema Claude Code, Model Context Protocol e ferramentas de IA para desenvolvimento permite três conclusões principais:

1. O MCP representa avanço estrutural com componente de cascata.

A migração de plugins proprietários para protocolo aberto reduz custos de transação de integração de forma mensurável -- o problema N x M é real e a solução N + M é genuinamente superior. A velocidade de adoção (de experimento a padrão de facto em 12 meses) reflete tanto mérito técnico quanto cascata informacional (Banerjee, 1992). A doação à Linux Foundation (AAIF) em dezembro de 2025, com participação de Anthropic, Block e OpenAI como membros fundadores e AWS, Google, Microsoft e Cloudflare como membros platinum, adiciona legitimidade institucional e mecanismo de governança que protege contra captura por player individual. Contudo, como demonstram Rietveld e Schilling (2021), governança aberta não impede concentração prática -- o risco de lock-in de ecossistema permanece e deve ser monitorado.

2. Existe bolha especulativa parcial, com ganhos contexto-dependentes e heterogêneos.

Os dados configuram padrão consistente com bolha parcial: aumento de uso simultâneo à diminuição de satisfação, valuations desconectadas de retornos demonstráveis, cascatas informacionais de plataforma, frustração documentada de 66% com outputs "quase certos". Floridi (2024) identifica as cinco características compartilhadas com bolhas anteriores. A tecnologia subjacente é real e produz ganhos mensuráveis em contextos específicos -- Peng et al. (+55,8%), Brynjolfsson et al. (+14%, QJE), Cui et al. (+26,08%) -- mas o estudo METR (Becker et al., 2025) demonstra que para desenvolvedores experientes em projetos complexos, o resultado pode ser negativo (-19%). O efeito nivelador documentado por Brynjolfsson et al. no QJE -- +34% para novatos, ganho mínimo para seniores -- é o achado mais robusto e replicado, sugerindo que o valor primário da IA para codificação é democratização de competência, não ampliação de expertise existente.

3. O posicionamento no Vale da Desilusão sinaliza maturação, não fracasso.

O posicionamento da IA Generativa no Vale da Desilusão do Gartner Hype Cycle 2025 é indicador de recalibração de expectativas, não de obsolescência tecnológica. O padrão histórico é claro: tecnologias que atravessam esse vale -- internet, computação em nuvem, mobile -- emergem como infraestrutura permanente. Tecnologias que não o atravessam (Second Life, Google Glass na primeira iteração, 3D TV) não tinham fundamento de valor suficiente. O framework de Perez (2002) sugere que a bolha atual pode servir função econômica de financiamento de infraestrutura -- a infraestrutura de computação, dados e protocolos (incluindo MCP) sendo construída agora será utilizada nas décadas seguintes, independentemente de quais empresas específicas sobreviverão ao ciclo. Contudo, Acemoglu e Johnson (2023) lembram que prosperidade compartilhada não é automática: depende de escolhas institucionais, não de determinismo tecnológico. A questão não é apenas se a IA funciona, mas quem se beneficia e como os ganhos são distribuídos.

Recomendação:

Organizações devem adotar ferramentas de IA para desenvolvimento com base em critérios mensuráveis -- mensurabilidade, reversibilidade, interoperabilidade, governança e custo real de transação -- e não por pressão mimética ou cascata informacional. Privilegiar padrões abertos (MCP sobre integrações proprietárias), manter capacidade de reversão, investir em governança de outputs e mensurar impacto rigorosamente. Avaliar custos de troca antes que a adoção se aprofunde e manter competências que transferem entre ferramentas.

A função de uma ferramenta de IA não é gerar hype, mas reduzir custos de transação reais entre intenção e resultado.

Referências

ACEMOGLU, D.; JOHNSON, S. Power and Progress: Our Thousand-Year Struggle Over Technology and Prosperity. New York: PublicAffairs, 2023. ISBN 978-1541702530.

AMODEI, D. Machines of Loving Grace: How AI Could Transform the World for the Better. Ensaio pessoal, out. 2024. Disponível em: https://www.darioamodei.com/essay/machines-of-loving-grace. Acesso em: 10 fev. 2026.

ANTHROPIC. Anthropic Economic Index Report: Economic Primitives. Anthropic Research, jan. 2026. Disponível em: https://www.anthropic.com/research/anthropic-economic-index-january-2026-report. Acesso em: 10 fev. 2026.

ANTHROPIC. How AI Is Transforming Work at Anthropic. Anthropic Research, ago. 2025. Disponível em: https://www.anthropic.com/research/how-ai-is-transforming-work-at-anthropic. Acesso em: 10 fev. 2026.

BANERJEE, A. V. A Simple Model of Herd Behavior. The Quarterly Journal of Economics, v. 107, n. 3, p. 797-817, 1992.

BECKER, C. et al. Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity. arXiv preprint, arXiv:2507.09089, jul. 2025.

BRYNJOLFSSON, E.; LI, D.; RAYMOND, L. R. Generative AI at Work. The Quarterly Journal of Economics, v. 140, n. 2, p. 889-942, 2025. DOI: 10.1093/qje/qjae044.

CB INSIGHTS. Who's Winning the AI Coding Race? CB Insights Research Report, dez. 2025. Disponível em: https://www.cbinsights.com/research/report/coding-ai-market-share-december-2025/. Acesso em: 14 fev. 2026.

CHEN, Y. et al. Model Context Protocol (MCP) at First Glance: Studying the Security and Maintainability of MCP Servers. arXiv preprint, arXiv:2506.13538, jun. 2025.

CUI, Z. et al. The Effects of Generative AI on High-Skilled Work: Evidence from Three Field Experiments with Software Developers. SSRN Electronic Journal, ago. 2025. Disponível em: https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4945566. Acesso em: 14 fev. 2026.

FENN, J.; RASKINO, M. Mastering the Hype Cycle: How to Choose the Right Innovation at the Right Time. Boston: Harvard Business Press, 2008.

FLORIDI, L. Why the AI Hype is Another Tech Bubble. Philosophy & Technology, v. 37, n. 105, 2024. DOI: 10.1007/s13347-024-00817-w.

GARTNER. Gartner Magic Quadrant for AI Code Assistants. Gartner Research, set. 2025. Disponível em: https://www.gartner.com/en/documents/6948266. Acesso em: 14 fev. 2026.

GREPTILE. State of AI Coding 2025. Greptile Research, 2025. Disponível em: https://www.greptile.com/blog/state-of-ai-coding-2025. Acesso em: 14 fev. 2026.

HASAN, S. et al. Model Context Protocol (MCP): Landscape, Security Threats, and Future Research Directions. arXiv preprint, arXiv:2503.23278, mar. 2025.

LINUX FOUNDATION. Linux Foundation Announces the Formation of the Agentic AI Foundation (AAIF). Linux Foundation Press Release, 9 dez. 2025. Disponível em: https://www.linuxfoundation.org/press/linux-foundation-announces-the-formation-of-the-agentic-ai-foundation. Acesso em: 14 fev. 2026.

MCKINSEY & COMPANY. Unleashing Developer Productivity with Generative AI. McKinsey Digital, 2024. Disponível em: https://www.mckinsey.com/capabilities/tech-and-ai/our-insights/unleashing-developer-productivity-with-generative-ai. Acesso em: 14 fev. 2026.

NAGLE, F.; SEAMANS, R.; TADELIS, S. Transaction Cost Economics in the Digital Economy: A Research Agenda. Strategic Organization, v. 23, n. 2, p. 351-365, maio 2025. DOI: 10.1177/14761270241228674.

PENG, S. et al. The Impact of AI on Developer Productivity: Evidence from GitHub Copilot. arXiv preprint, arXiv:2302.06590, fev. 2023.

PEREZ, C. Technological Revolutions and Financial Capital: The Dynamics of Bubbles and Golden Ages. Cheltenham: Edward Elgar, 2002. ISBN 978-1843763314.

RIETVELD, J.; SCHILLING, M. A. Platform Competition: A Systematic and Interdisciplinary Review of the Literature. Journal of Management, v. 47, n. 6, p. 1528-1563, 2021. DOI: 10.1177/0149206320969791.

SANTOS, V. et al. Decoding the Configuration of AI Coding Agents: Insights from Claude Code Projects. arXiv preprint, arXiv:2511.09268, nov. 2025.

SECOND TALENT. AI Developer Tools Market Report 2024. Second Talent Research, 2025.

SECURITY vulnerabilities of Copilot-Generated Code in GitHub Projects: An Empirical Study. ACM Transactions on Software Engineering and Methodology, 2025. DOI: 10.1145/3716848.

SHAPIRO, C.; VARIAN, H. R. Information Rules: A Strategic Guide to the Network Economy. Boston: Harvard Business School Press, 1999. ISBN 978-0875848631.

SHILLER, R. J. Irrational Exuberance. 3. ed. Princeton: Princeton University Press, 2015. ISBN 978-0691166261.

STACK OVERFLOW. Developer Survey 2025. Stack Overflow, 2025. Disponível em: https://survey.stackoverflow.co/2025/. Acesso em: 14 fev. 2026.

STANFORD UNIVERSITY. INSTITUTE FOR HUMAN-CENTERED ARTIFICIAL INTELLIGENCE (HAI). AI Index Report 2025. Stanford: Stanford HAI, 2025. Disponível em: https://hai.stanford.edu/ai-index/2025-ai-index-report. Acesso em: 14 fev. 2026.

SUN, H. A Longitudinal Study of Herd Behavior in the Adoption and Continued Use of Technology. MIS Quarterly, v. 37, n. 4, p. 1013-1042, dez. 2013. DOI: 10.25300/MISQ/2013/37.4.02.

VERGARI, C. Herd Behaviour in Adoption of Network Technologies. Journal of Economics, v. 86, n. 2, p. 161-182, 2005. DOI: 10.1007/s00712-005-0153-7.

WILLIAMSON, O. E. The Economic Institutions of Capitalism. New York: Free Press, 1985. ISBN 978-0029348208.

Perguntas Frequentes (FAQ)

O que é o Claude Code e como difere de outros assistentes de IA para codificação?

O Claude Code é um agente de codificação desenvolvido pela Anthropic que opera em terminal, IDEs (VS Code, JetBrains, Cursor), interface web e aplicação desktop. Diferentemente de ferramentas de autocompleção como o GitHub Copilot, o Claude Code funciona como agente autônomo: pode executar sequências de ações em repositórios de código, coordenar subagentes especializados, interagir com sistemas externos via MCP e manter memória de projeto via arquivo CLAUDE.md. A distinção central é entre assistência pontual (sugerir próxima linha de código) e agência (planejar e executar tarefas de codificação de ponta a ponta).

O que é o Model Context Protocol (MCP) e por que importa?

O MCP é um protocolo aberto baseado em JSON-RPC 2.0 que padroniza a comunicação entre modelos de IA e ferramentas ou fontes de dados externas. Importa porque resolve o problema N x M de integração: sem protocolo padrão, cada modelo de IA precisa de integração customizada com cada ferramenta, gerando N x M implementações. Com MCP, a complexidade reduz-se para N + M. Analogia: antes do USB, cada periférico precisava de conector específico; o USB padronizou a interface e permitiu ecossistema amplo. O MCP visa fazer o mesmo para a conexão entre IA e ferramentas.

A IA para codificação realmente melhora a produtividade?

As evidências são heterogêneas e contexto-dependentes. Estudos controlados mostram ganhos de +55,8% em tarefas simples (Peng et al., 2023) e +26% em contexto empresarial (Cui et al., 2025), mas o estudo METR (Becker et al., 2025) documentou perda de 19% para desenvolvedores experientes em projetos complexos. O padrão mais robusto é o efeito nivelador: novatos ganham significativamente (+34%), enquanto seniores ganham pouco ou perdem. A resposta honesta: depende de quem usa, para que tarefa e em que contexto.

Estamos em uma bolha de IA?

Os dados indicam bolha parcial. Cinco indicadores são consistentes com dinâmica de bolha: (1) uso crescente com satisfação decrescente; (2) valuations desconectadas de retornos; (3) cascatas informacionais de plataforma; (4) narrativas dominantes ("IA muda tudo") similares a bolhas anteriores; (5) frustração documentada de 66% dos desenvolvedores. Contudo, diferentemente de bolhas puras (onde não há valor subjacente), a IA para codificação produz ganhos mensuráveis em contextos específicos. O framework de Perez (2002) sugere que bolhas tecnológicas servem função econômica de financiar infraestrutura -- a infraestrutura de IA sendo construída agora provavelmente sobreviverá ao estouro da bolha especulativa.

Como avaliar se minha organização deve adotar Claude Code ou ferramentas similares?

Cinco critérios objetivos: (1) Mensurabilidade -- defina métricas de sucesso antes da adoção e compare com baseline; (2) Reversibilidade -- verifique se a decisão pode ser revertida sem custo proibitivo; (3) Interoperabilidade -- prefira ferramentas com padrões abertos (MCP) sobre integrações proprietárias; (4) Governança -- estabeleça processos de revisão humana, monitoramento de qualidade e segurança; (5) Custo real -- considere treinamento, integração, manutenção, riscos de segurança e custos de troca, não apenas licenciamento.

O MCP gera lock-in mesmo sendo protocolo aberto?

Paradoxalmente, sim -- mas de forma diferente. O MCP reduz lock-in de ferramenta (qualquer cliente MCP comunica-se com qualquer servidor MCP), mas pode gerar lock-in de ecossistema (o ecossistema MCP em si torna-se a plataforma). Analogia: HTTP é aberto, mas o ecossistema web gera lock-in para o modo de trabalho web. A governança pela Linux Foundation (AAIF) mitiga parcialmente, mas dados de market share já mostram concentração em três players (>70%). Recomendação: investir em competências transferíveis (engenharia de software, revisão de código, design de sistemas) além de competências específicas de ferramenta.

Sobre o Autor

Ivan Prizon é Economista pela Universidade Estadual de Maringá (UEM), Mestre em Economia do Desenvolvimento pela Universidade Federal de Santa Maria (UFSM) e Doutorando em Políticas Públicas -- Política de Inovação pela Universidade Federal do Paraná (UFPR). É Chief Technology Officer e sócio-fundador da Agência Integrare, onde desenvolve metodologias de marketing baseadas em evidências fundamentadas em Economia Institucional e Economia Comportamental.

Contato: [email protected] | aintegrare.com.br

Sobre a Integrare

A Agência Integrare é especializada em estratégias de marketing digital baseadas em evidências. Combinamos fundamentação teórica em Economia Institucional, Economia Comportamental e análise de dados para desenvolver soluções que reduzem custos de transação entre empresas e seus públicos ideais.

Conheça nossos serviços ou entre em contato para discutir como podemos ajudar sua organização.

Este artigo é parte da Working Paper Series da Agência Integrare (WP-2026-002). Gostou desta análise? Assine nossa newsletter para receber conteúdo aprofundado sobre tecnologia, estratégia e marketing baseado em evidências.

Integrare

A Integrare é especializada em soluções de integração e automação de processos empresariais, ajudando organizações a otimizar suas operações e alcançar melhores resultados através da tecnologia.

Receba insights exclusivos sobre integração e automação

Assine nossa newsletter e fique por dentro das últimas tendências, melhores práticas e estudos de caso em tecnologia empresarial.

Sem spam. Cancele quando quiser. 🔒

Artigos relacionados

A Economia da Autenticidade: Marketing como Infraestrutura de Redução de Custos de Transação e o Conceito de Público-Ideal

Por que a autenticidade corporativa não é questão moral, mas condição de eficiência alocativa? Este artigo desenvolve uma teoria econômica da autenticidade fundamentada na Economia dos Custos de Transação, na teoria da sinalização e na economia evolucionária. Introduz o conceito de público-ideal como distinção analítica do público-alvo convencional e reconceituou o marketing como infraestrutura de coordenação que reduz custos de transação.

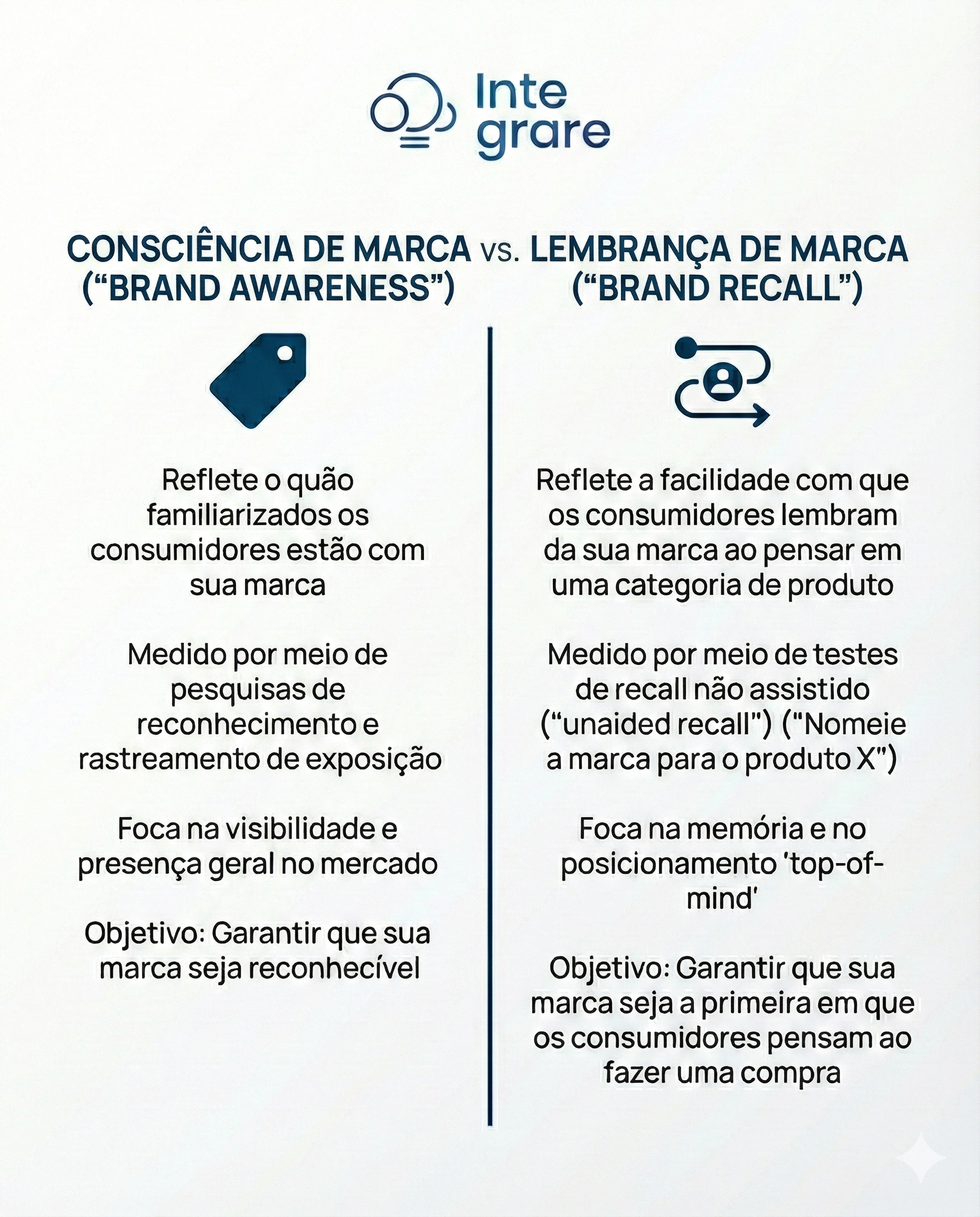

Brand Awareness vs Brand Recall: Fundamentos Neurocognitivos e Implicações Estratégicas para Redução de Custos de Transação

A distinção entre brand awareness e brand recall é fundamental para estratégias de marketing que reduzam custos de transação. Este artigo examina os mecanismos neurocognitivos subjacentes e suas implicações para construção de saliência de marca.

Marketing como Infraestrutura de Redução de Custos de Transação: Uma Abordagem pela Economia Institucional

Por que marketing deveria ser tratado como infraestrutura econômica e não como despesa variável? Este artigo reconceituou o marketing a partir da Teoria dos Custos de Transação (Coase, Williamson, North), demonstrando que investimentos estratégicos em marketing reduzem custos de busca, negociação e execução para ambos os lados da transação. Analisa a decisão make-or-buy, o contexto brasileiro de custos estruturalmente elevados e o efeito de retornos crescentes via path dependence.